NVIDIA 與微軟共同推出符合業界標準的超大規模GPU加速器 促進AI雲端運算發展

NVIDIA (輝達) 今天宣布與微軟 (Microsoft) 攜手合作,揭曉全新專為驅動人工智慧 (AI) 雲端運算的超大規模 (hyperscale) GPU 加速器藍圖。

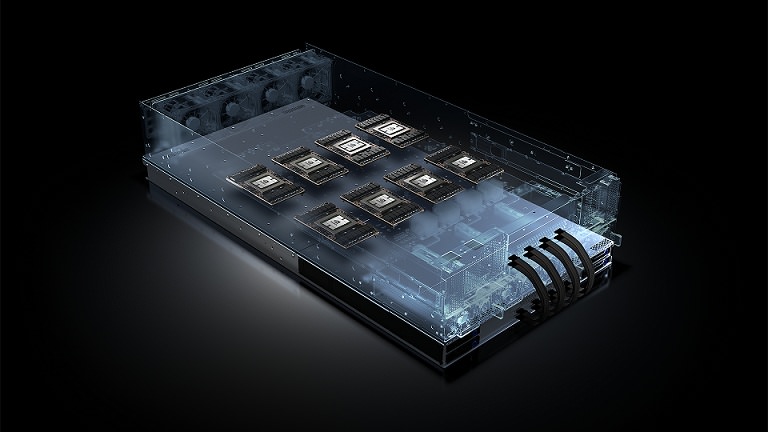

全新 HGX-1 是一款結合微軟 Project Olympus 開源設計的超大規模 GPU 加速器,提供超大規模資料中心於人工智慧快速且具彈性的途徑。

HGX-1 適用於基於雲端的人工智慧作業負載,如同二十多年前為PC 主機板所推出ATX (Advanced Technology eXtended)時的角色一般,HGX-1 建立了一項業界標準,能快速且有效的被採用以協助達到急速增長的市場需求。

全新架構設計是為滿足 AI 雲端運算的爆炸性需求,其領域包含自動駕駛、個人醫療照護、超越人類的語音辨識、數據與影像分析以及分子模擬等。

NVIDIA 公司共同創辦人暨執行長黃仁勳表示:「AI為全新的運算模型,因此需要全新的架構支援。HGX-1 超大規模 GPU 加速器在AI雲端運算所扮演的角色,如同過去 ATX 標準使現在PC 能夠普及一樣。HGX-1 將使雲端服務供應商能更輕易的透過 NVIDIA GPU 滿足激增的AI 運算需求。」

微軟公司總經理暨 Azure 硬體基礎架構部門傑出工程師 Kushagra Vaid 於部落格表示:「HGX-1 AI 加速器提供極至效能擴充以達成快速成長的機器學習作業負載需求,同時,其特殊的設計使現今全球各地的資料中心皆能輕易採用。」

對於全球數千家已投資 AI 與採納基於 AI 作業方法的企業與新創公司而言,HGX-1 的架構在雲端上展現了前所未有的配置管理與效能。

HGX-1 在每部主機皆配置 8 顆 NVIDIA® Tesla® P100 顯示卡,其特色在於使用以 NVIDIA NVLink™ 互聯技術與 PCle 標準為基礎的創新轉換設計,使 CPU 能夠任意與多顆 GPU 進行連接。這讓在 HGX-1 基礎架構標準化的雲端服務業者,能提供客戶各種 CPU 與 GPU 的機器配置。

雲端作業較以往更加的多樣化且複雜。AI 訓練、推論和高效能運算 (HPC) 作業負載透過 CPU 連結至不同數量的 GPU,以最佳的方式運行於不同的系統配置中。不論作業負載量多大,HGX-1 的高度模組化設計使其能以最佳的效能運行。同時,HGX-1 提供較傳統基於 CPU 的伺服器快達 100 倍的深度學習效能,卻僅有五分之一的執行 AI 訓練成本與十分之一的 AI 推論成本。

HGX-1 透過與全球各地資料中心合作的高度彈性,提供目前超大規模資料中心用於 AI 領域快速且簡單的途徑。

透過合作將業界標準推伸至超大規模層級

微軟、NVIDIA 和鴻海子公司鴻佰科技 (Ingrasys) 共同合作打造 HGX-1 平台的架構與設計,為微軟 Project Olympus 貢獻 Open Compute Project 的一部分,並將此資源開放分享。Open Compute Project 目標將開源效益應用於硬體上,並迅速提高資料中心內外的創新腳步。

利用廣大的 Open Compute Project 社群分享相關的參考設計意味著企業能夠輕易的購買或部署相同的設計於他們自己的資料中心。

NVIDIA 加入 Open Compute Project

NVIDIA 加入 Open Compute Project 以幫助驅動資料中心的 AI 技術和革新,並計畫將持續與微軟、鴻佰科技和其他成員的合作,一同為雲端服務供應商和其他資料中心客戶升級 AI-ready 運算平台。

掌握 NVIDIA 最新動態

請訂閱 NVIDIA 官方部落格或追蹤 Facebook 、 Google+ 、 Twitter 、 Linkedin 與 Instagram 。瀏覽 NVIDIA 相關影片及圖片,請至 YouTube 或 Flickr 。

臉書留言