英特爾舉行「AI Everywhere」發表會!宣布推出Intel Core Ultra處理器

英特爾在美國紐約當地時間12月14日舉行「AI Everywhere」發表會,會上推出無與倫比的AI產品組合,使客戶的AI解決方案無處不在,從資料中心、雲端、網路、邊緣到PC。

主要亮點:

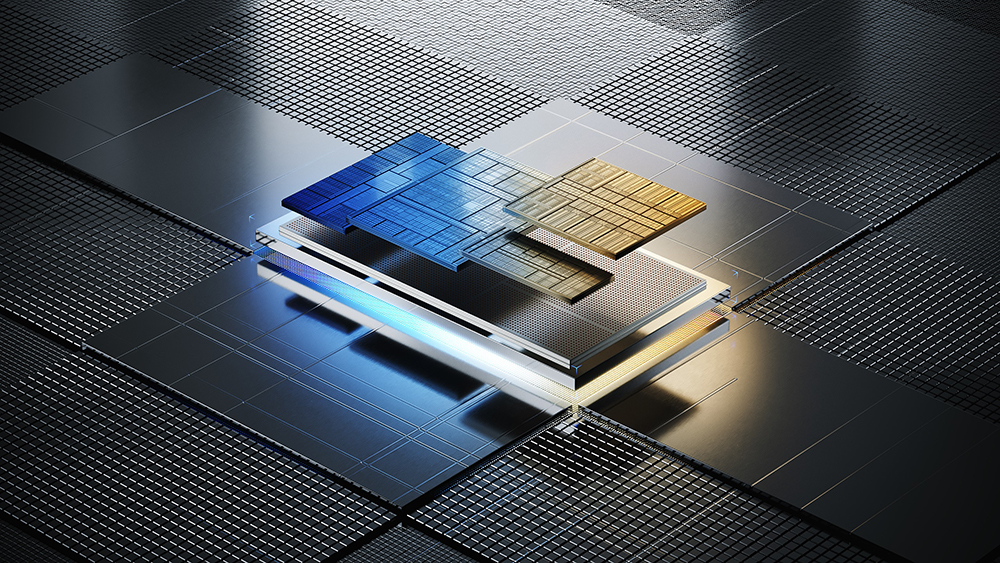

- Intel® Core™ Ultra處理器為首款基於Intel 4製程技術的處理器,象徵著公司40年來最大的架構轉變,提供英特爾最節能的處理器並將引領AI PC時代。

- 第5代Xeon®處理器在每個核心中內建AI加速功能,帶來AI和整體效能的提升,並降低總持有成本(TCO)。

- 英特爾執行長Pat Gelsinger(基辛格)首次展示了將於明年推出的Intel® Gaudi®3 AI加速器。

英特爾執行長Pat Gelsinger表示:「AI創新有望將數位經濟的影響提升至全球總生產毛額的三分之一[i]。英特爾正在發展使客戶能夠在所有應用之間無縫整合並有效運行AI的技術和解決方案,包括在雲端,以及越來越多資料產生和使用的終端上。」

呼應英特爾全球AI重要時刻,英特爾也在台灣正式發布全系列產品線,包括Intel® Core™ Ultra處理器(代號:Meteor Lake)、第5代Xeon®處理器(代號:Emerald Rapids),以及介紹最新版本的OpenVINO™ 2023.2工具套件。英特爾同時攜手合作夥伴,現場展示10台基於Intel® Core™ Ultra的PC,以及超過25台基於第5代Xeon®處理器的系統和主機板,展現合作夥伴與台灣產業生態系強大的研發能量。

英特爾副總裁暨台灣分公司總經理汪佳慧表示:「英特爾的使命是透過精心規劃的平台、安全的解決方案和對開放生態系統的支持,讓AI無所不在。隨著今天全系列新產品的推出,我們的AI產品組合變得更加強大。同時,我們也獲得供應鏈生態系的支持,展現與合作夥伴共同發展下一代產品的最新成果,以及一起探索AI應用的無限可能。」

Intel® Core™ Ultra驅動AI PC和新應用

作為搭載Intel 4製程技術的首款處理器,Intel® Core™ Ultra象徵著公司40年來最大的架構轉變。Intel® Core™ Ultra處理器將引領AI PC時代,是一款在運算、圖形、功耗、電池壽命和AI體驗全方面效能都表現出色的處理器。Intel® Core™ Ultra搭載首次推出的AI加速器—神經處理單元(NPU),能實現全新水平的高效能AI加速,比前一代產品提高了2.5倍的能源效率[ii]。

此外,英特爾正與100多家獨立軟體供應商緊密合作,將數百種AI應用程式導入PC市場,一系列高度創意、高效且有趣的應用將改變PC使用體驗。對於消費者和商用客戶來說,相對於競爭平台而言,這意味著在Intel® Core™ Ultra上將能執行更廣泛的AI應用。例如,Adobe Premiere Pro的內容創作者將能享受到比競爭產品高達40%的性能[iii]。

搭載 Intel® Core™ Ultra的AI PC現已在多家美國零售商上市。預估明年度全球將有超過230款筆記型電腦和個人電腦採用Intel® Core™ Ultra處理器。展望2028年[iv],AI PC將占整體個人電腦市場八成,驅動工作、學習和創作的新應用。

活動現場亦展示來自宏碁、華碩、戴爾、神基科技、技嘉科技、聯想、LG、微星科技等合作夥伴的10台基於Intel® Core™ Ultra的PC(依廠商英文名順序排列)。

新一代Xeon處理器為資料中心、雲端、網路和終端帶來更強大的AI能力

第5代Xeon®處理器帶來了效能和效率上的顯著提升[v]。在相同熱設計功耗(TDP),下,平均效能提升 21%[vi],每瓦效能提升 36%[vii]。若遵循普遍的五年更新周期,從舊一代系統升級到新一代Xeon處理器的客戶其TCO可降低高達77%[viii]。

Xeon是市場唯一內建AI加速功能的主流資料中心處理器。全新第5代Intel® Xeon®處理器在多達200億參數的模型上,提供高達42%的推論和微調效能提升[ix]。它也是唯一一款具有一致且不斷改善MLPerf訓練和推論基準測試結果的CPU。

透過Xeon內建的AI加速器,搭配最佳化的軟體和強化的遙測功能,為通訊服務提供者、內容提供者,以及包括零售、醫療保健和製造等廣泛垂直市場,提供更輕鬆的管理、更有效率的布署複雜的網路和邊緣運算負載。

第5代Xeon®處理器也獲得合作夥伴的肯定。IBM在其watsonx.data平台上發表了第5代Intel® Xeon®處理器的測試結果,其搜尋傳輸量(Query Throughput)比上一代Xeon處理器提高了2.7倍。Google Cloud預計在明年導入第五代Xeon®,並指出Palo Alto Networks在使用Google Cloud的第4代Xeon®的內建加速功能時,威脅偵測深度學習模型的性能提高了2倍。獨立遊戲工作室Gallium Studios轉而使用在Xeon處理器上執行的Numenta AI平台,相較在基於GPU的雲端平台上,其推論性能提高6.5倍,有效降低其AI遊戲Prox的成本和時延。這種卓越性能為先進的AI開啟了新的可能性,不僅在資料中心和雲端,更延伸至全球網路和邊緣運算的應用。

活動現場也展示超過25台基於第5代Intel® Xeon®處理器的系統和主機板,產品來自營邦企業、華擎科技、華碩、研華科技、仁寶科技、富士康工業互聯網、技嘉科技、廣積科技、鴻佰科技、英業達、立端科技、神雲科技、微星科技、新漢、和碩聯合科技、雲達科技、美超微、緯創、緯穎科技等合作夥伴(依廠商英文名順序排列)。

此外,英特爾也宣布Intel® Xeon® E-2400正式上市。此入門級伺服器專為中小企業與裸機雲端託管(Entry-level bare metal cloud hosting)而設計。具備伺服器等級的可靠性,高成本效益和可管理性功能,提供高達5.6 GHz時脈、支援DDR5和PCIe 5.0,並具備Intel極致渦輪加速技術3.0(Intel® Turbo Boost Max Technology 3.0)。

滿足開發者所需的AI加速和解決方案

Intel® Core™ Ultra 和第 5 代Xeon®未來都將進入大眾從未想像過的應用場域。想像一下,根據客人的預算和飲食需求提供餐點選擇的餐廳、從源頭上發現品質和安全問題的廠房、可以看見人眼無法辨識的物品的超音波、精準管理電力的智慧電網。這些邊緣運算應用代表了增長最快的運算領域,其全球市場規模預計到本世紀末將激增至4,450億美元,其中AI的工作負載增長最為快速,而終端和客戶端設備對AI推論的需求是資料中心的 1.4 倍。

英特爾除了提供可靠的AI硬體技術,更致力提升使用效率及體驗,將AI加速功能融入開發者使用的AI框架(如PyTorch和TensorFlow),並透過oneAPI提供基礎函式庫,使軟體在不同類型的硬體上進行最佳化,以大幅提升運作效能。英特爾的開放式oneAPI和OpenVINO™工具套件,提供開發者運用硬體加速來處理AI工作負載和解決方案,能快速建立、最佳化和布署AI模型,適用於各種推論應用。

英特爾最新版本的Intel® OpenVINO™ 2023.2,針對深度學習推論的開源軟體庫,增強對生成式與大型語言模型(LLM)的支援,開發人員可以透過OpenVINO™在本地端或雲端直接布署AI推論,讓開發人員能夠更順暢的轉換模型,無需通過針對不同類型硬體的底層API重構模型,加速實現混合式AI。

Intel® OpenVINO™ 2023.2版本主要更新:

- 提升使用者體驗:PyTorch模型轉換更容易,並增加Hugging Face生態系統中的可用性和OpenVINO™在C/C++開發者使用的套件管理器。

- 生成式AI和大型語言模型(LLM)效能增強:在Intel® Core™ CPU和iGPU上加速LLM模型推論,使用INT8模型壓縮,支援動態形狀,預覽支援INT4模型格式。

- 更高可攜性和性能:通過啟用FP16模型格式和整合額外加速庫來提高LLM的性能和降低延遲。

臉書留言